Por Cecilia Lucca

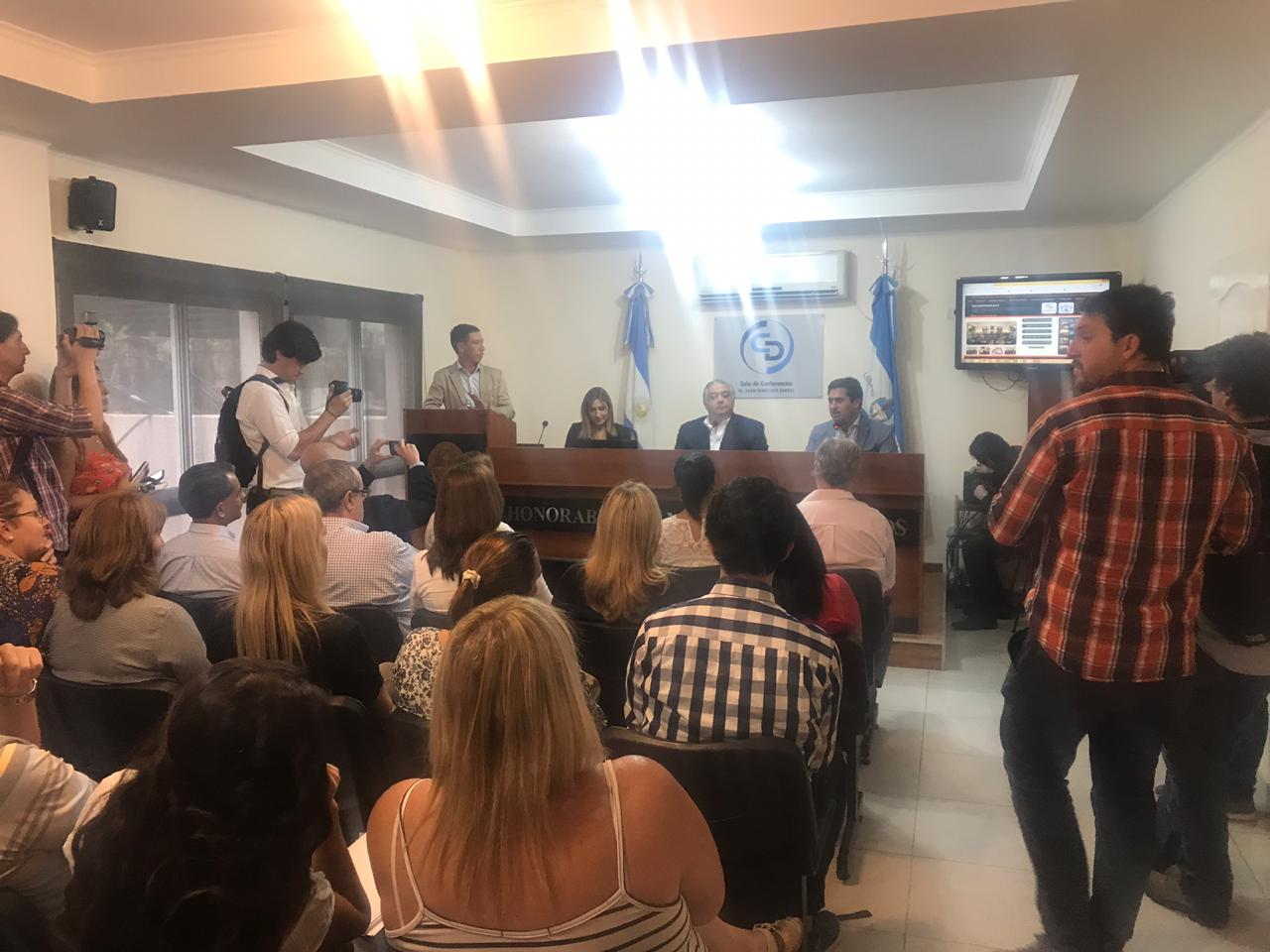

Con el taller de Acceso a la Información Pública Parlamentaria, dictado en la Legislatura de Corrientes el día 6 de diciembre, se cerró el ciclo 2018 de seminarios orientados a colaborar con las legislaturas provinciales en la organización de su propia oficina de Acceso a la Información Pública.

En septiembre de 2016 se sancionó en Argentina la Ley de Derecho de Acceso a la Información Pública (ley N° 27.275). Esta ley tiene por objeto de promover la participación ciudadana, la transparencia de la gestión pública y garantizar el acceso a la información pública. Si bien la ley obliga a los tres poderes del Estado Nacional, en su artículo 36 invita a las provincias a adherir a la ley. Provincias como Mendoza han tomado la iniciativa de dictar su propia legislación con alcance análogo. Las que ya contaban con ley provincial se encuentran trabajando en su implementación y otras analizan si adherir a la ley nacional o dictar su propia normativa.

Más allá de la forma en que cada provincia se adapte a lo ordenado por la ley 27.275, corresponde a cada cámara legislativa provincial resolver qué tipo de organización le dará a su oficina de acceso a la información parlamentaria, y qué procesos dictará para ello. Es en este marco que la Fundación Nuevas Generaciones en cooperación internacional con el International Republican Institute (IRI) , y la Honorable Cámara de Diputados de la Nación (HCDN), ha desarrollado el “Programa de Acceso a la Información Pública Parlamentaria”. Al respecto, Julián Obiglio, Director Ejecutivo de la Fundación, indicó que este Programa “permite a las legislaturas provinciales acceder a expertos de primera línea, con amplia experiencia en el tema, y que pueden allanarles el camino en la definición de estándares y la implementación de la normativa”.

Los seminarios, cuyos programas buscaron adaptarse a cada contexto local, contaron con la participación de diversos funcionarios nacionales, como Fernanda Araujo, Directora Nacional de Relaciones con la Comunidad y Participación Ciudadana, del Ministerio del Interior, Obras Públicas y Vivienda; Fernando Sanchez, Secretario de Fortalecimiento Institucional; y Gabriela Commateo y Mercedes Nassif, de la Honorable Cámara de Diputados de la Nación.

Participaron también como expositores Cecilia Lucca, experta en gobierno abierto; Sofía Devalle, Directora de la Oficina de Técnica de Transparencia Presupuestaria de la Legislatura de Córdoba, y Micaela Amorós de la Universidad Nacional de Cuyo.

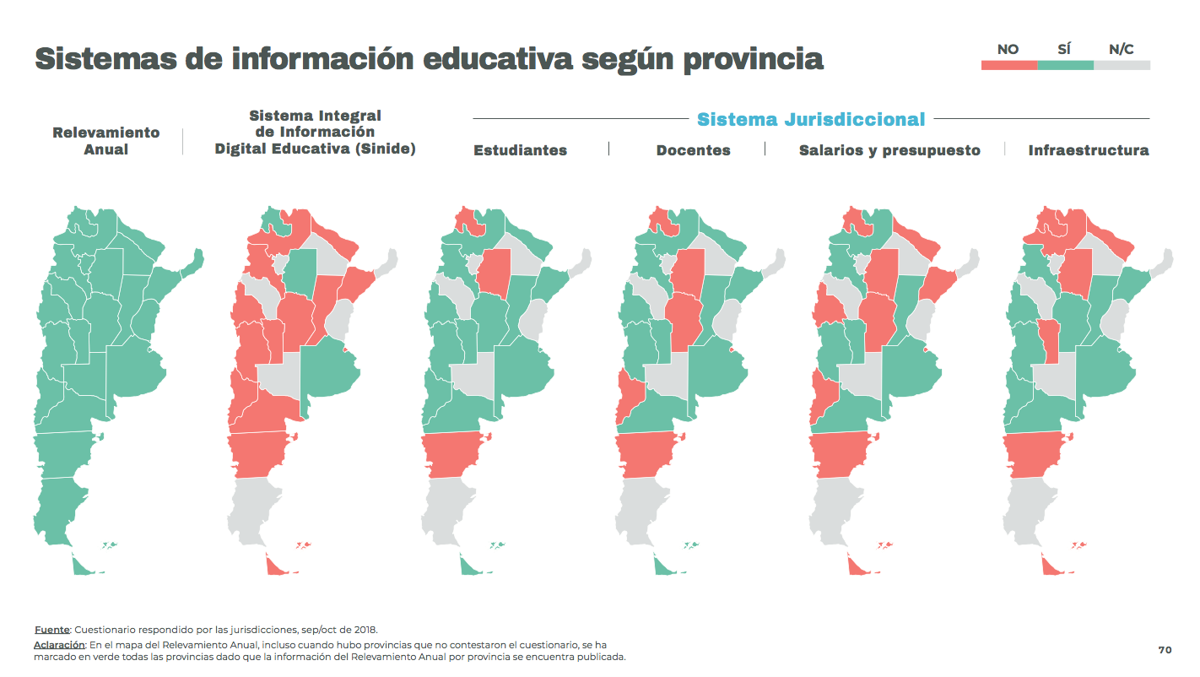

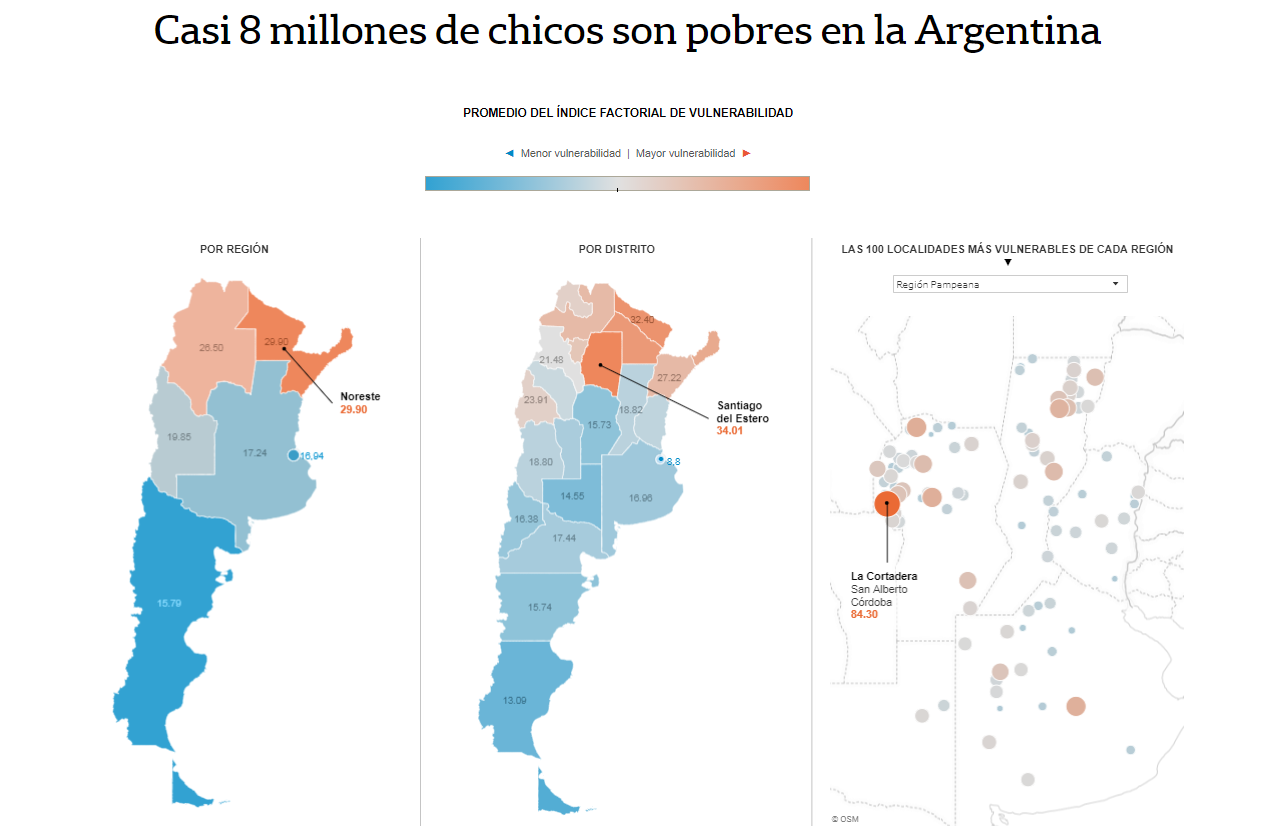

Del equipo de La Nación Data participaron Bianca Pallaro y Gabriela Bouret, aportando la visión de los grandes usuarios de datos gubernamentales, y transmitiendo a los funcionarios de las legislaturas locales cómo es el proceso mediante el cual los datos se convierten en información periodística, de utilidad e interés general para la sociedad.

El Programa, que tiene como objetivo alcanzar todas las legislaturas del país en los próximos cinco años, comenzó en el segundo semestre de 2018, y ya ha desarrollado talleres de capacitación en las legislaturas de Mendoza, Córdoba y Corrientes. Luego del receso legislativo de verano, continuará con otras provincias que en breve serán definidas.