En el Tow Center de Columbia University se llevó a cabo un panel auspiciado por ONA “Doing Data Journalism”. Los congregados fueron Julia Angwin (WSJ), Scott Klein (ProPublica), Jo Craven McGinty (NYT), Aron Pilhofer (NYT), Ashkan Soltani y Mo Tamman (Reuters). Susan E. McGregor (CU) resultó una excelente anfitriona y moderadora.

¡Ví el video 3 veces! Realmente muy enriquecedor el debate. Todos ofrecieron agudas reflexiones y mucha información. Si pueden entenderlo en inglés no duden en verlo entero. Me resultó apasionante y diré que, en muchos momentos, ¡sin censura!

Jo Craven McGinty del New York Times, todo un hallazgo.

Descubrí varios personajes nuevos pero voy a concentrarme en ella.

En 1995, realizó una Maestría de Periodismo con Base de Datos en la Universidad de Missouri, cuna de varios data ninjas.

Revisando un dataset con registros de homicios del FBI, encontró que faltaba información sobre varios homicidios causados por policías, pero ahí quedó la cosa. Al terminar sus estudios, ingresó al Washington Post donde sugirió retomar la investigación e integró el team que ganó un Pulitzer Prize for Public Service en 1999 con esta historia de corrupción policial.

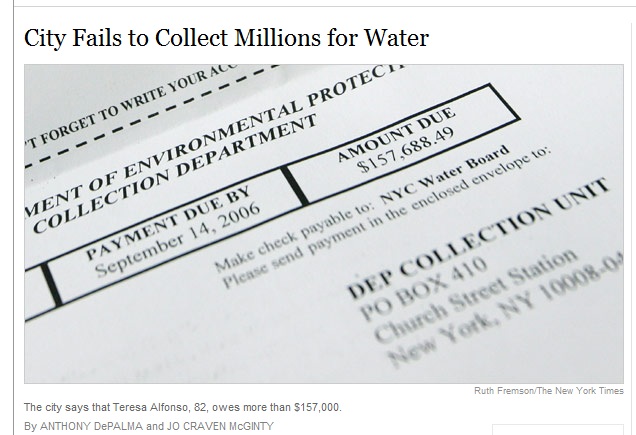

Jo mencionó otro caso donde la historia surgió a partir de la imposibilidad de armar un data set coherente. Fue en relación a facturas de agua impagas en la ciudad de Nueva York. Supusieron que muchos podían pagar y no lo hacían, aprovechándose de la inoperancia del gobierno. En efecto, las sumas adeudadas resultaron un agujero negro ante la desprolijidad en la gestión.

Con respecto a herramientas de visualización, las utiliza para “consumo personal”. Es decir, para analizar información. Destacó el uso de software de mapeo, charts de Excel, etc. que le facilitan detectar puntas de investigación.

Por último, concluye de su experiencia personal que, entre estar sentada en una sección específica (estuvo en Metro) o junto al Data Team, le resulta profesionalmente más enriquecedora esta última opción. Le permite continuar aprendiendo de las conversaciones diarias entre el equipo. Eso sí, su desafío es que las distintas secciones de la Redacción no se olviden de involucrarla en historias que podrían incluir bases de datos.

En la Redacción: Números versus testimonios.

Lo que más me impresionó de todo el video fueron dos testimonios de Tamman y Pilhofer.

Ambos fueron consultados por sendos compañeros de redacción por una historia en desarrollo. Los dos hicieron una devolución negativa con fundamento en base de datos y al poco tiempo, la historia salió publicada con los errores oportunamente advertidos por ellos.

La conclusión de ambos es que todavía en las redacciones suelen ser más valorados los testimonios, anécdotas o percepciones empíricas frente a la contundencia de las bases de datos.

Pilhofer lo comenta muy enojado a partir del minuto 42:00. ¡Creo que después se arrepintió de haberlo compartido! Seguir leyendo →